- 8 optimisations technique pour faciliter le crawl de Google

- 1- Les outils d’analyse

- 2- Un hébergement performant

- 3- Pas d’erreur http pour que les pages soient accessibles

- 4- Créer un site mobile first

- 5- Choisir un CMS performant

- 6- Suivre les Core Web Vitals

- 7- Contrôler le crawl de Google

- 8- Les autres travaux à mener

- Les autres critères d’autorité EEAT

Le SEO technique n’a qu’un seul objectif : Réduire le temps de traitement du crawl des moteurs de recherche (le crawl budget) pour qu’ils indexent rapidement toutes les pages d’un site web. Plus le crawl est efficace et rapide, plus l’exploration est complète et profonde.

L’optimisation des critères techniques doit se faire sur tous les supports, mais surtout sur les mobiles depuis le filtre « first index mobile » de Google en 2016.

Le SEO technique est une des trois composantes du SEO (technique, contenu et popularité) qui définissent l’autorité d’un site internet sur son marché.

8 optimisations technique pour faciliter le crawl de Google

Le travail d’optimisation SEO technique d’un site web consiste à réduire le temps de chargement des pages pour obtenir des résultats parfaits afin de proposer une expérience utilisateur de grande qualité.

Les résultats d'un travail réussi donnent un site rapide et sécurisé, qui s'apprécient grâce à des outils spécifiques et qui donnent des résultats proches de ceux ci-dessous.

Voici les meilleurs conseils d'expert pour travailler votre SEO technique et faire de votre site web une excellente expérience utilisateur

1- Les outils d’analyse

Pour travailler efficacement, vous devez utiliser des outils adaptés pour analyser les performances techniques de votre site. Voici les outils gratuits de Google, mais il en existe d’autres :

- Google search console analyse les métriques techniques des pages (vitesse, données structurées, optimisation mobile, erreurs de pages, trafic, mots clés, nombre de clics, etc)

- Google analytics analyse le trafic et les comportements des visiteurs

- Google pagesspeed calcule le temps de chargement d’une page. C’est l’outil ultime pour analyser le travail de SEO technique d’un site

2- Un hébergement performant

Un mauvais hébergement peut ralentir le temps de chargement des pages et ainsi augmenter le taux de rebond (l’internaute quitte le site sans ouvrir de seconde page), tout en réduisant le temps de lecture. Il peut aussi créer des failles de sécurité dans lesquelles les hackeurs peuvent s’infiltrer pour mettre votre site en erreur 404, le remplacer par un autre, poser des backlinks discrets vers leur site, l’utiliser comme serveur de spam à leur profit, faire du clickjacking, de l’injection de code, une attaque XSS, Etc.

Le choix de l’hébergeur dépend avant tout de son infrastructure : Capacité de stockage, espace de stockage, types de technologies, bandes passantes, sécurité des données, redondance des serveurs, localisation des serveurs et des IP, support technique et services annexes.

En fonction de votre budget, de vos compétences techniques et de vos intérêts commerciaux, vous avez le choix entre

- Un serveur dédié qui permet une optimisation technique complète en toute autonomie, mais le budget est réservé aux projets plus importants et aux ingénieurs systèmes expérimentés

- Un serveur mutualisé, qui est facile à administrer et peu couteux, mais qui n’offre aucune possibilité de customisation de l’infrastructure

3- Pas d’erreur http pour que les pages soient accessibles

Pour que tout fonctionne, il faut que le serveur renvoie en permanence un code 200, ce qui signifie que tout fonctionne correctement. Veillez à surveiller les pages orphelines et les liens cassés pour ne pas avoir d’erreur 400 ou 500.

- 200 : succès de la requête

- 301 et 302 : redirection, respectivement permanente et temporaire

- 401 : utilisateur non authentifié

- 403 : accès refusé

- 404 : ressource non trouvée

- 500, 502 et 503 : erreurs serveur

- 504 : le serveur n’a pas répondu

Voici un bon outil pour scanner le site afin de vérifier que les entêtes http sont fiables : screamingfrog

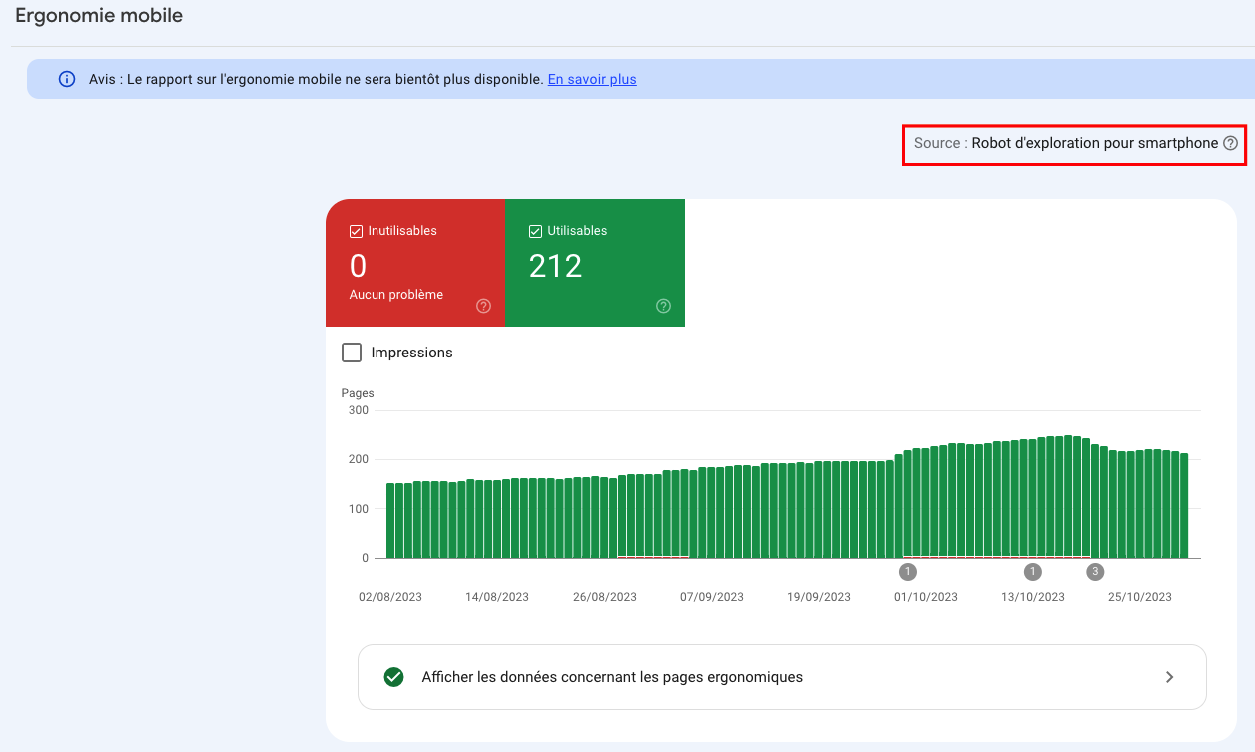

4- Créer un site mobile first

Google a annoncé en mai 2023 que la version mobile de tous les sites de la planète est indexée prioritairement à la version ordinateur. Pour savoir si votre site est dans l’index mobile de Google, Rendez Vous dans la search console et vérifiez par vous même.

Le projet Mobile-First Index est un filtre stratégique de Google qu’il faut impérativement mettre en priorité haute de votre travail SEO technique.

Notre conseil est de concevoir un site en premier pour les mobiles et d’en faire une version pour desktop

5- Choisir un CMS performant

Près de la moitié des sites internet dans le monde sont gérés par un CMS (45% pour les ordinateurs et 47% pour les mobiles en 2022), mais ce chiffre est à analyser plus en profondeur, car plus de 93% des 1000 plus gros sites mondiaux utilisent un développement privé et pas un CMS. Les raisons du choix d’un CMS par les petites entreprises sont naturellement le coût, la facilité de mise en oeuvre, les besoins limités en ressources humaines et en infrastructure. WordPress reste le CMS open source ultra leader avec 35% du du marché mondial. [(*) Source le blog du modérateur]

- WordPress a de nombreux avantages : Simple, ergonomique, intuitif, compatible avec de nombreux plugins, pas cher à administrer. C’est le CMS parfait pour un blog ou le site vitrine d’une entreprise.

- Mais WordPress a plusieurs énormes problèmes incompatibles avec les enjeux du SEO technique : Il est très lourd, les pages sont très lentes à télécharger, il doit être mis à jour régulièrement, car il y a beaucoup de failles de sécurité. Comme il prend énormément de place dans les serveurs de Google, le moteur de recherche semble ne pas l’aimer.

Google semble mettre aujourd’hui un « red flag » sur chaque nouveau site wordpress qui arrive sur la toile, tout montre à penser que le moteur de recherche préfère les sites statiques, beaucoup plus légers et moins gourmands en espace disque et en bande passante, comme le site cliKizi.com

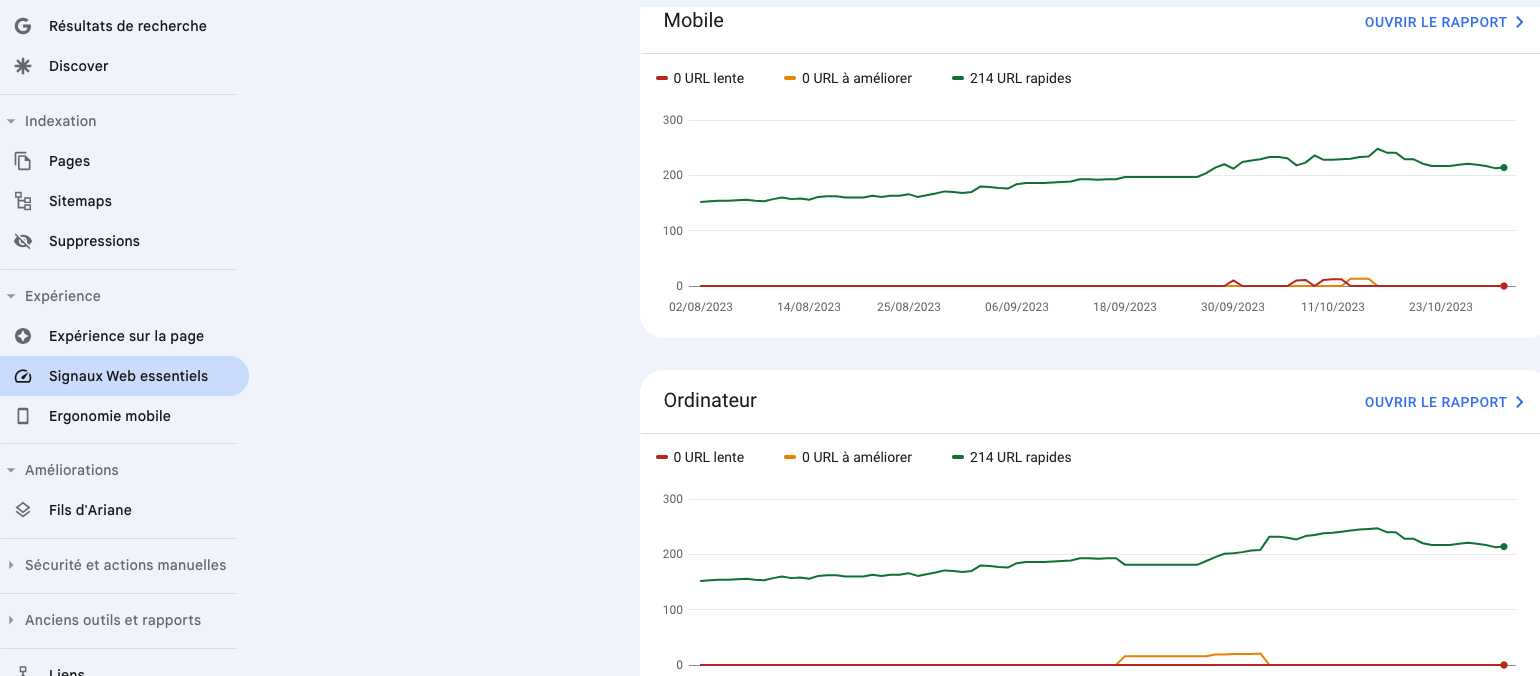

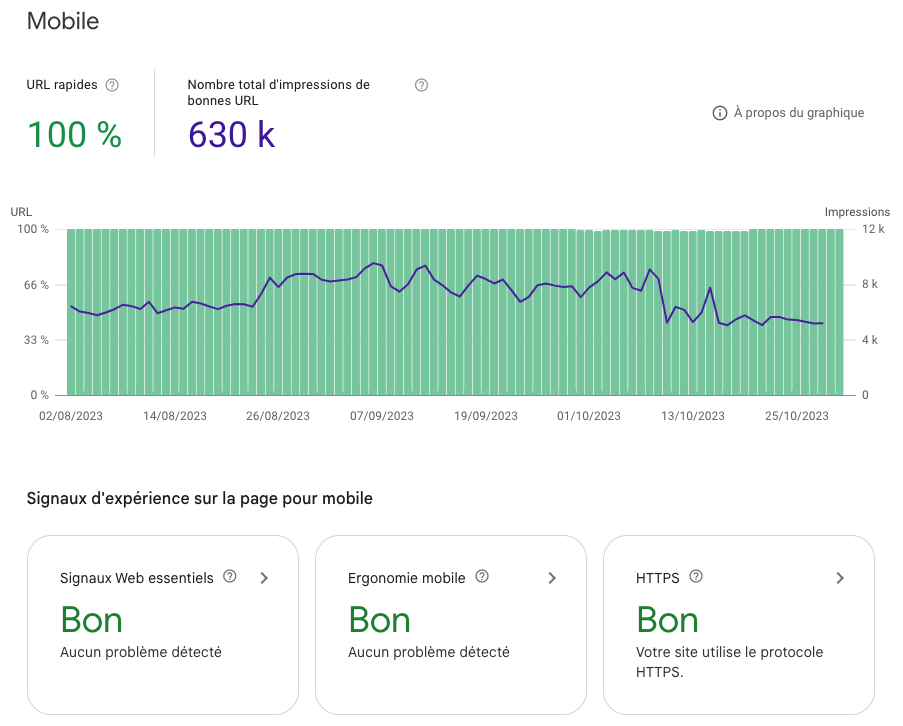

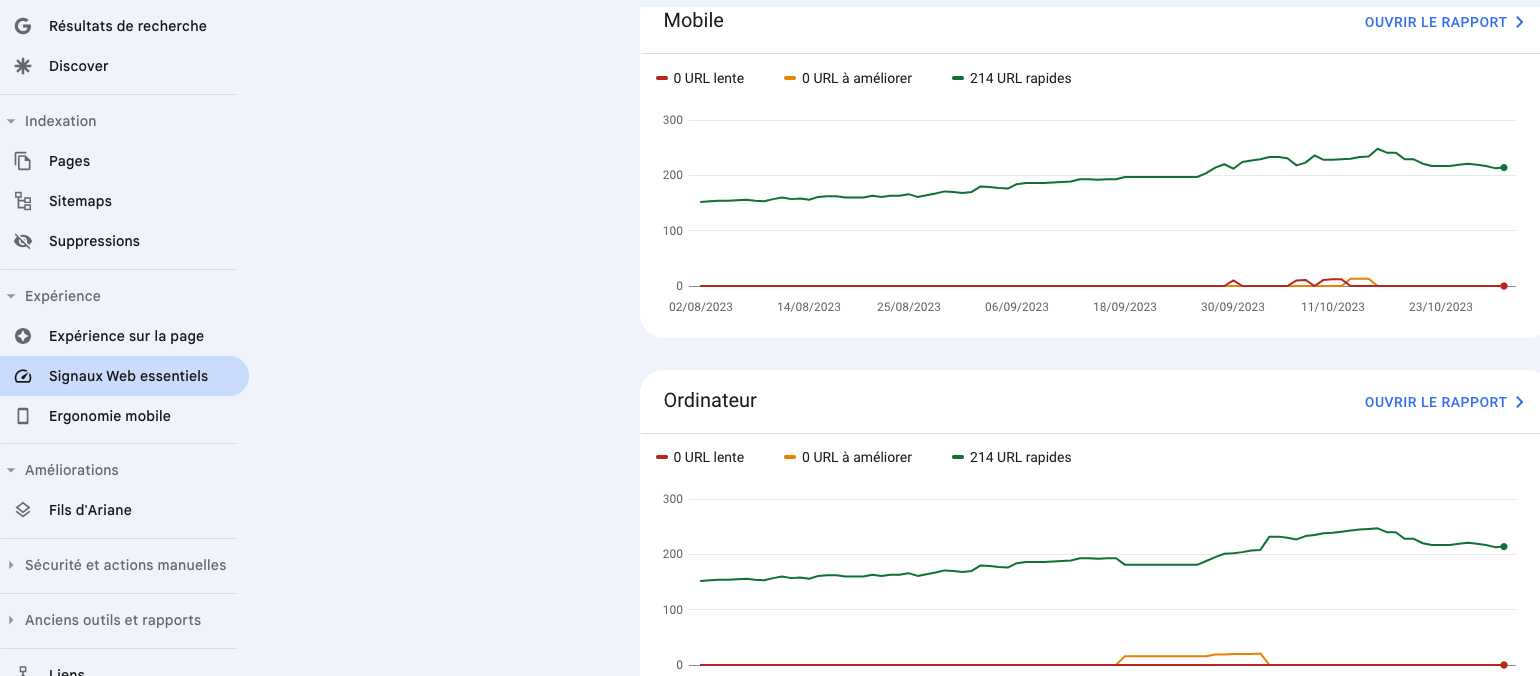

6- Suivre les Core Web Vitals

Les Core Web Vitals, Signaux Web Essentiels regroupent des critères techniques pris en compte par Google pour évaluer l’expérience utilisateur. Les meilleurs scores de Core Web Vitals sont réservés aux sites qui apportent à l’internaute de l’information tout en offrant une excellente expérience utilisateur.

Evaluation de l’expérience utilisateur

- Temps de chargement de la page < 2000 ms sur mobile

- Pas de temps de latence à l’affichage des visuels images, vidéos et autres

- Du texte suffisamment gros pour être lu par tous

- Affichage immédiat des éléments dynamiques

Largest Contentful Paint ou LCP

C’est le temps de chargement de l’élément le plus lourd de la page. C’est souvent une photo qui ralentit l’affichage complet d’une page. Attention, ce critère ne doit pas être confondu avec le temps de chargement d’une page.

Cumulative Layout Shift CLS

Le CLS désigne la stabilité d’une page lorsqu’elle s’affiche.

First Input Delay FID

Le First Input Delay mesure le temps que met votre site à réagir à une action du navigateur (clic sur un bouton ou un lien). Un FID <100 ms est jugé correct.

Vous trouverez les signaux web essentiels dans la Google search console.

7- Contrôler le crawl de Google

- Un sitemap XML indique à Google les pages les plus importantes, les dates de mise à jour, la fréquence des modifications, la ou les langues. Il existe plusieurs types de sitemap XML à intégrer en fonction de vos contenus : sitemap pour pages de textes, pour photos, videos, pour différentes langues, etc. Le sitemap XML ne détermine pas si le site s’indexe bien ou non, mais il désigne certains critères d’indexation à Google.

- Le robots.txt autorise ou interdit l’accès à Google à certaines parties du site pour éviter qu’il ne perde du temps à crawler inutilement des ressources.

- En parallèle du sitemap et du robots txt, l’obfuscation des liens empêche Google de perdre du temps à crawler des pages sans intérêt en lui bloquant l’accès aux liens du header, du footer, de la navigation à facette, Etc.)

- C’est une prestation technique assez complexe qui contribue à optimiser le budget crawl (réduire le temps de crawl) et à faire du page rank sculpting (optimisation du maillage interne en hiérarchisant les pages mère, filles et soeurs, les landings et pages de vente). C’est une technique indispensable pour tout site, mais surtout pour optimiser la puissance d’un cocon sémantique.

8- Les autres travaux à mener

- Google recommande à tous les développeurs de placer une balise canonique sur chaque page. C’est un code HTML mis en place par Google et utilisé pour indiquer aux moteurs de recherche quelle version d’une page web est à prendre en compte

- Pensez à optimiser vos images, à compresser la taille de vos fichiers Javascript et CSS, déplacez vos fichiers sur un CDN et à optimiser vos url

- Pensez aussi à intégrer les balises shema.org, qui permettent aux moteurs de comprendre de quoi traite la page

- N’oubliez pas le plugin RGPD qui est obligatoire en Europe

Les autres critères d’autorité EEAT

Noubliez pas que le SEO pour doper votre référencement naturel n’est pas qu’un seul travail technique. Pour que votre site puisse espérer être en première position, vous devez dans un premier temps publier du contenu utile pour le lecteur et parfaitement optimisé pour le SEO (travail sur les balises Hn, Title et meta description, le maillage interne). Dans un second temps mettez en place des campagnes de netlinking et développez le nombre de backlinks entrants.